„Guten Abend meine Damen und Herren. Ich begrüße Sie zur Tagesschau.“ Seit Jahrzehnten ist im Ersten dieser Satz um 20 Uhr nach dem berühmten Gong zu hören. Lange galt die Tagesschau für die allermeisten als seriös und vertrauenswürdig. Seit einiger Zeit steckt sie aber – wie der gesamte öffentlich-rechtliche Rundfunk – in einer Vertrauenskrise.

Immer wieder versuchen Gegner des öffentlich-rechtlichen Rundfunks, das Vertrauen in ihn weiter zu untergraben. Mit dem aktuellen KI-Hype werden dafür Mittel wie gefakte Audios eingesetzt.

Jüngstes Beispiel: Geklonte Stimmen der Tagesschau-Sprecherin Susanne Daubner und dem Tagesschau-Sprecher Jens Riewa, verpackt mit Tagesschau-Jingle, entschuldigen sich dafür, dass die Tagesschau ihren Zuschauern „dreist ins Gesicht lügt“. Über diese gefälschten Audiodateien hat Ralf Caspary mit David Beck aus der SWR-Wissenschaftsredaktion gesprochen.

Um Stimmen zu klonen braucht es nicht viel

Ralf Caspary: Wie werden solche Fakes gemacht?

David Beck: Schwer ist das wirklich nicht mehr. Es gibt Dienste im Internet, mit denen das sehr einfach, sehr günstig und durch Probeabos zum Teil sogar kostenlos möglich ist. Alles, was dafür gebraucht wird, sind Sprachaufnahmen in guter Qualität. Von Nachrichtensprecherinnen und Nachrichtensprechern gibt es davon naturgemäß mehr als genug. Es reichen bereits 30 bis 60 Sekunden, um ein gutes Ergebnis zu erzielen.

Dann kann einfach aufgeschrieben werden, was die geklonte Stimme sagen soll, dazu wird dann ein Audio generiert. Bei diesen einfachen, günstigen Diensten hat man allerdings recht wenig Kontrolle darüber, wie sich das Gesprochene anhört. Aspekte wie die Sprachmelodie und Betonungen, das macht die KI ein bisschen, wie sie will. Insgesamt dauert das Ganze nur ein paar Minuten.

Tagesschau-Fake: Wie einfach ist es, Jens Riewa zu fälschen?

Ralf Caspary: Wie hört sich das dann an?

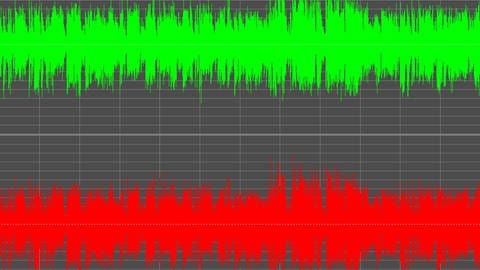

David Beck: Dass es sich um eine Fälschung handelt, ist oft nicht ganz eindeutig erkennbar, aber es gibt manchmal Auffälligkeiten wie ungewöhnliche Betonungen, ein mechanischer Klang und eine seltsame Sprachmelodie. So hören sich Stimmen oft an, wenn sie mit einfachen Diensten geklont werden.

Bei den Tagesschau-Fakes ist das besonders am Ende zu hören, wo dann echte Verabschiedungen von Susanne Daubner und Jens Riewa reingeschnitten wurden.

Dabei dürfen wir nicht vergessen, dass die Technik immer besser wird. Damit wurden die Fakes in den letzten Jahren einerseits deutlich besser, andererseits ist es sehr einfach geworden, sie zu benutzen und für alle besser zugänglich.

Bei Zweifeln an der Echtheit beim vermeintlichen Absender nachsehen

Ralf Caspary: Wenn die Fakes immer besser werden, gibt es denn dann Möglichkeiten, sie als solche zu erkennen?

David Beck: Es wird immer wichtiger, dass wir uns bei Inhalten aus Social Media oder die wir sonst von Dritten bekommen, Gedanken machen, wie plausibel das ist, war wir da sehen uns hören. In Falle der Tagesschau-Fakes zum Beispiel hört sich die Formulierung so gar nicht nach der Tagesschau an. Da würde so eine Richtigstellung viel diplomatischer klingen als „wir haben Ihnen dreist ins Gesicht gelogen“.

Beim Faktenfinder auf tagesschau.de gibt es auch einen Artikel darüber, dass es sich hier um Fakes handelt – was wesentlich glaubwürdiger ist als dass die Audios echt sind, weil der Artikel aus erster Hand kommt. Im Zweifel ist es also eine Möglichkeit, einem Fake auf die Schliche zu kommen, indem man beim vermeintlichen Absender nachschaut oder nachfragt.

Natürlich kann man auch darauf nicht immer vertrauen, aber in diesem Fall würde es keinen Sinn machen, wenn die Redaktion sich einerseits für die vermeintlichen Lügen entschuldigt, dann aber die Entschuldigung auf ihrer Homepage leugnet.

Ralf Caspary: Wie ist denn die rechtliche Situation? Es ist schon strafbar, solche Fakes zu erstellen, oder?

David Beck: Hier könnten ein paar Straftaten zusammenkommen. Zum Beispiel könnte es üble Nachrede sein. Außerdem wurden die Stimmen von Susanne Daubner und Jens Riewa vermutlich ohne deren Zustimmung geklont, was datenschutz- und natürlich persönlichkeitsrechtlich schwierig werden kann.

In Sozialen Medien sind diese Audiodateien oft mit dem Vermerk „Satire“ versehen. Das ist aber wahrscheinlich nicht für das Zielpublikum gedacht, sondern um sich später auf die Kunstfreiheit berufen zu können und einer strafrechtlichen Verfolgung zu entgehen.

Das Ziel solcher Fakes ist sicherlich, das Vertrauen in die Tagesschau und den öffentlich-rechtlichen Rundfunk zu schädigen – das ist besonders dann absurd, wenn es aus der Ecke kommt, die uns vorwirft, wir würden die Falschnachrichten verbreiten.