Im Jemen hat eine autonome Drohne möglicherweise erstmals ohne Befehl einen Menschen angegriffen. Darauf deutet ein Bericht der Vereinten Nationen hin. Eine Studie unter Beteiligung des Forschungsbereichs Mensch und Maschine am Max-Planck-Institut zeigte Anfang des Jahres auf, dass Künstliche Intelligenz – kurz KI – nicht allein mit Algorithmen kontrollierbar sei. Sind selbstbestimmte Maschinen also schon zur Realität geworden?

Kann sich künstliche Intelligenz der Kontrolle des Menschen entziehen?

Wenn es möglich ist, dass Evolution es schafft, aus Materie ein menschliches Bewusstsein zu bauen, dann gibt es ja nichts prinzipielles, was uns davon abhalten sollte, ein Bewusstsein nachzubauen oder etwas zusammenzubasteln, das dann von sich aus ein Bewusstsein entwickelt. Also das ist eigentlich eine fast schon religiöse Frage.

Stimmt es, dass KI nicht vollständig kontrolliert werden kann?

Da müssen wir uns ganz dringend über den Begriff der Künstlichen Intelligenz unterhalten. Denn das ist eigentlich ein sehr schlechter Name für eine Ansammlung von Methoden, mit denen wir als Informatiker:innen in Daten der Vergangenheit nach Mustern suchen, um damit Entscheidungen in der Zukunft treffen zu können.

Vielleicht werden diese Methoden irgendwann dazu führen, dass wir tatsächlich auch eine Maschine haben, die sich selbst Ziele setzt. Das ist aber im Moment überhaupt nicht so, sondern wir setzen das Ziel. Wir wählen die Daten aus.

Die Maschine hat Algorithmen, mit denen sie nach statistisch relevanten Mustern sucht. Die werden von Menschen eigentlich noch mal begutachtet und dann eingesetzt. Im Moment müssen wir die Menschen kontrollieren, die diese KI Systeme einsetzen. Die KI selbst hat kein eigenes Bewusstsein und wird sie in den nächsten 10 bis 15 Jahren auch nicht entwickeln.

Müssen wir uns jetzt schon Gedanken machen, wie man eine KI vollständig kontrolliert?

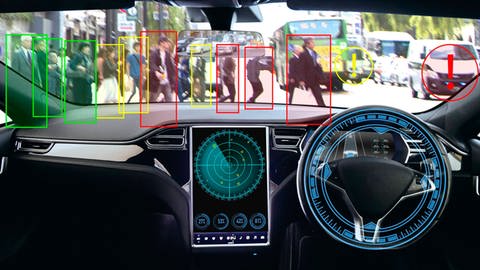

Haben Sie Hunde oder Kinder? Haben sie die vollständig unter Kontrolle? Dasselbe Problem haben wir mit KI auch, wenn wir sie aus Daten der Umgebung lernen lassen. Wir haben also zum Beispiel einem autonomen Fahrzeug, das versucht, mit Hilfe von Kamerabildern bewegliche und stationäre Objekte, wie Häuser oder Fahrräder zu erkennen. Wir sagen dem System: Das war wirklich ein Fahrrad, das hast du gut gemacht, oder das ist gar kein Hund gewesen, hätte sie nicht bremsen müssen.

Diese Richtlinien, die wir dem Computer sagen, dieses Erfahrungslernen - das ist so ein bisschen wie das, was wir bei unseren Kindern versuchen. Da bleibt ein Rest Unsicherheit, wenn wir die Erziehungsregeln schlecht formulieren. Das haben wir wahrscheinlich auch schon alle erlebt, dass wir gedacht haben. den Kindern einen klaren Auftrag zu geben und die mit irgendeiner Interpretation dieses Auftrages um die Ecke kommen und was ganz anderes gemacht haben.

Genauso muss man sich das bei den Maschinen auch vorstellen. Man versucht zum Beispiel, Maschinen den Unterschied zwischen Pferden und Hunden klarzumachen und man nimmt nur Pferdebilder von einem und demselben Pferdefotografen, der überall sein Logo drauf macht. Dann lernt die Maschine halt das Logo zu erkennen. Dann ist es ihr egal, welcher Vierbeiner auf dem Bild zu sehen ist. Und deswegen ist es so schwierig.

Eine vollständige Kontrolle werden wir mit dieser Art von Software nicht haben. Aber trotzdem kann man sich wie bei Kindern einigermaßen sicher sein, ob man die jetzt gut erzogen hat oder nicht.

Brauchen intelligente Systeme einen Not-Aus Knopf?

Ich glaube, dass wir nicht so gut darin sind, auf den ersten Wurf eine vollständig gelungene Erziehungsregel zu basteln. Wenn die Maschine dann einen Umweg findet, um der Rede zu gehorchen und trotzdem was ganz anderes zu machen, dann ist das natürlich schon eine gefährliche Sache, wenn wir diesen Maschinen Möglichkeit geben, auf die Umwelt einzuwirken. Wenn das dann auf Stromnetzwerke einwirken kann oder Ähnliches, halte ich das für gefährlich.

Deswegen würde ich persönlich davon abraten, solche starke KI zu bauen. Ob die Leute auf mich hören werden, das ist natürlich irgendwie naiv gedacht. Also jedes Land kann das für sich entscheiden, ob sie eine solche Technologie bauen will. Ich kann davon nur abraten.

Autonomer Drohnenangriff im Jemen – Macht das Angst?

Erstmal muss man den Begriff der Autonomie noch mal klären. Die Drohne ist autonom in dem Sinne, dass sie versucht, Personen auf den Kameradaten zu erkennen und dann selbständig schießen kann. Die Maschine merkt: Da ist ein Mensch in einem Gebiet, wo er nicht sein sollte. Und damit wird dann ein Maschinengewehr getriggert.

Die Autonomie darf man hier nicht überinterpretieren. Das ist insofern kontrollierbar, als dass ich der Maschine einfach nicht die Möglichkeit gebe, direkt den Abschuss zu machen. Warum das nicht erfolgt ist, das ist eine politische Frage, das ist eine Machtfrage. Aber tatsächlich hätte das nicht passieren dürfen.

So macht mir das Angst, dass Menschen in Zusammenhang mit sehr mächtigen KI Systemen ungleich viel mehr Macht haben können als vorher. Das macht mir auf jeden Fall Sorge. Aber nicht so sehr die Maschine, sondern der Machtzuwachs für einzelne Menschen und einzelne Menschengruppen.

Künstliche Intelligenz – Fluch oder Segen?

Die KI, die wir jetzt haben, könnten wir für ganz viel Segen einsetzen. Wir könnten den Autonomen Rollstuhl bauen. Wir könnten Kinder, deren Muttersprache nicht Deutsch ist einen eigenen Übersetzer zur Verfügung stellen. Kinder mit Leseschwierigkeiten könnten wir einen Vorlesealgorithmus zur Verfügung stellen. Ich glaube, wir sind in der Gestaltung von KI nur durch unsere Fantasie begrenzt.